AIに最適な量子化値を割り当てる低ビット量子化技術を開発

―従来比16分の1のビット数でも、認識精度の劣化を世界トップクラスの1.7%に抑制―

2021年6月21日

NEDO(国立研究開発法人新エネルギー・産業技術総合開発機構)

沖電気工業株式会社

NEDOと沖電気工業(株)(OKI)は、「高効率・高速処理を可能とするAIチップ・次世代コンピューティングの技術開発」において、AIの学習時に量子化値を最適に割り当てる低ビット量子化技術「LCQ(Learnable Companding Quantization)」を開発しました。本技術は、ディープニューラルネットワークの高精度モデルで、ビット数を32ビットから2ビットへと16分の1に圧縮しても画像認識精度の劣化を世界トップクラスの1.7%に抑えることに成功し、エッジ領域での演算負荷低減を実現します。

今後、本技術を活用することで、エッジ領域での高精細な画像認識、さらには工場のインフラ管理や機器の異常検知など、演算リソースの限られたデバイスでのAI実装を目指します。

本成果はコンピュータービジョン業界トップカンファレンスの国際学会である「CVPR(IEEE/CVF Computer Vision and Pattern Recognition、期間:2021年6月19日~25日、オンライン開催)」に採択され、OKIが発表する予定です。

1.概要

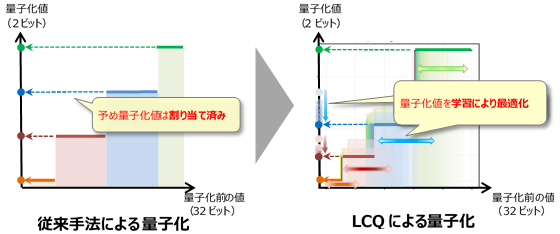

ディープニューラルネットワーク(DNN)※1は、画像や音声などの認識において優れた性能を発揮する人工知能(AI)として注目されています。一方で、高い精度を得るためには大量の演算リソースや電力が必要なため、メモリや電力に制限のあるエッジデバイスへの組み込みには課題がありました。そこで、演算負荷を下げるために、多くの乗算と加算により構成されるDNN演算を低ビットに量子化※2し、FPGA (Field-Programmable Gate Array)※3など専用のハードウェア上で実行する技術の研究開発が行われてきました。しかし、これまでの先行技術では、量子化する前の値に対する量子化後の値(量子化値)をあらかじめ固定値として割り当てるため、2ビットなどの超低ビットへ圧縮すると固定値との誤差により認識精度が劣化し、実用化への障壁となっていました。

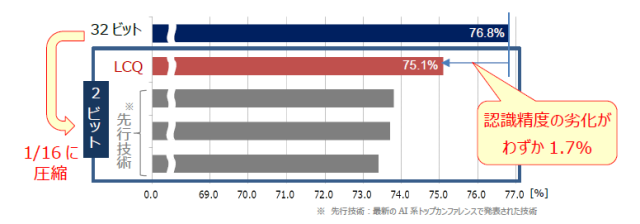

こうした背景のもと、国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)と沖電気工業株式会社(OKI)は、「高効率・高速処理を可能とするAIチップ・次世代コンピューティングの技術開発」(以下、本NEDO事業)※4において、DNNの学習時に、推論時の認識精度を維持するのに最適な低ビット量子化値を割り当てることができる低ビット量子化技術「LCQ(Learnable Companding Quantization)」を開発しました。DNNの性能をはかる指標(ベンチマーク)とされる画像認識で高精度モデルを32ビットから2ビットへと16分の1に圧縮した場合、先行技術では認識精度に約3%の劣化が生じるのに対し、LCQを適用することでこれを1.7%と非常に小さく抑えることに成功し、世界トップクラスの認識精度を達成しました(図1)。

-

図1 LCQによる量子化時の認識精度

図1 LCQによる量子化時の認識精度

なおこの結果はコンピュータービジョン業界トップカンファレスの国際学会であるCVPR(IEEE/CVF Computer Vision and Pattern Recognition、期間:2021年6月19日~6月25日、オンライン開催)に採択され、OKIが発表する予定です。

2.今回の成果

NEDOとOKIは音声符号化分野でよく扱われる非線形量子化技術Companding※5を応用したLCQにより、DNNの学習での量子化値を柔軟に割り当てることに成功しました。

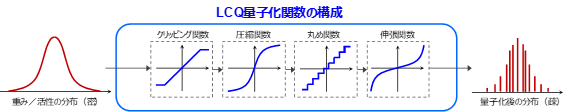

LCQではDNNの誤差勾配※6に基づいて圧縮関数と伸張関数※7を学習し、これを反映した量子化処理を行うことで(図2)、非線形な量子化関数が構築され、最適な量子化値を割り当てることが可能となります(図3)。低ビット量子化時の課題となっていた認識精度の劣化を抑制できるだけでなく、2ビットなど超低ビット量子化で高い効果を発揮することが確認でき、演算リソースが限られるエッジデバイスへのAI搭載が可能となります。

-

図2 LCQの概念図

-

図3 LCQによる量子化関数

3.今後の予定

OKIは本成果と本NEDO事業でOKIが開発したDNN演算数の削減が可能なAI軽量化技術PCAS※8を組み合わせ、演算負荷低減と演算数削減の両方の効果を得る技術の開発に取り組み、エッジ領域での高精細な画像認識、さらには工場のインフラ管理や機器の異常検知など、演算リソースの限られたデバイスでのAI実装を目指します。

【注釈】

- ※1 ディープニューラルネットワーク

- 多層ニューラルネットワーク。人間の脳の神経細胞(ニューロン)のつながりを模した数学モデルであるニューラルネットワークの層を、複数枚重ねて多層にしたものです。

- ※2 ニューラルネットワークの量子化

- 演算の入出力を細かい値から粗い値に近似することで演算負荷を低減する技術。一般に、細かい値を使う方が認識精度は高くなりますが、多くのビットが必要となり演算負荷が上がります。

- ※3 FPGA(Field-Programmable Gate Array)

- 製造後に設計者が再構成可能な集積回路です。

- ※4 NEDO事業

- 事業名称:高効率・高速処理を可能とするAIチップ・次世代コンピューティングの技術開発/革新的AIエッジコンピューティング技術の開発/ソフトテンソルプロセッサによる超広範囲センシングAIエッジ技術の研究開発

事業期間:2018年度~2020年度 - ※5 Companding

- Compressing(圧縮)とExpanding(伸張)を組み合わせた造語で、非線形量子化技術を表します。

- ※6 誤差勾配:

- 最適化させたい推論の誤差関数の傾き。DNNの学習でしばしば用いられる誤差逆伝搬法でも使用されています。

- ※7 圧縮関数と伸張関数

- 線形量子化演算の前後に通す関数。演算前に圧縮関数を通して情報を圧縮し、演算後に伸張関数を用いて復元します。

- ※8 AI軽量化技術PCAS

- 本NEDO事業においてOKIが開発した、ディープラーニングモデルの演算数を削減して軽量化する技術です。

- ディープラーニングモデルの新たな軽量化技術を開発(NEDOニュースリリース)

- ディープラーニングモデルの新たな軽量化技術を開発(OKIプレスリリース)

4.問い合わせ先

(本ニュースリリースの内容についての問い合わせ先)

NEDO IoT推進部 担当:広瀬、西山 TEL:044-520-5211

OKI広報部 担当:国江 TEL:03-3501-3835 E-mail:press@oki.com

(その他NEDO事業についての一般的な問い合わせ先)

NEDO 広報部 担当:橋本、坂本 TEL:044-520-5151 E-mail:nedo_press@ml.nedo.go.jp

関連ページ

- ネットワーク/コンピューティング

- 同分野のニュースリリースを探す

- 同分野の公募を探す

- 同分野のイベントを探す